Gérer les réseaux et le trafic¶

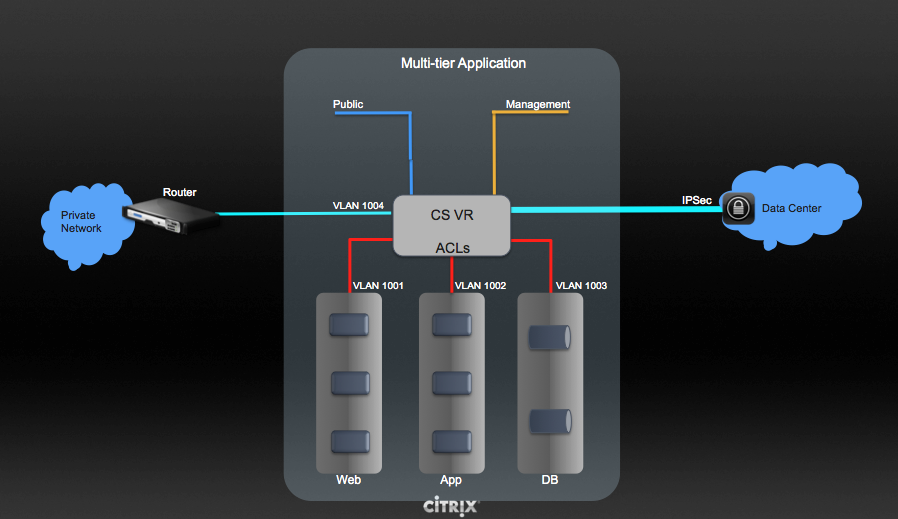

Dans CloudStack, les VMs invitées peuvent communiquer ensemble en utilisant les infrastructures partagées avec la sécurité et la perception que les utilisateurs ont un LAN privé. Le routeur virtuel CloudStack est le composant principal fournissant les fonctionnalités réseaux pour le trafic invité.

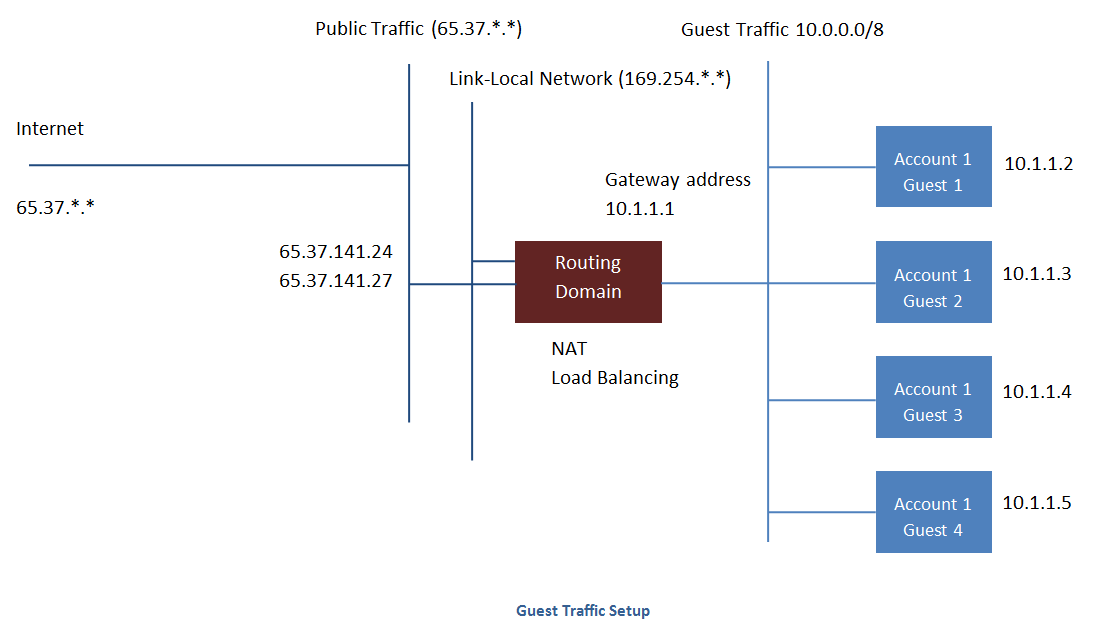

Trafic invité¶

Un réseau peut transporter le trafic invité seulement entre VMs à l’intérieur d’une zone. Les machines virtuelles de zones différentes ne peuvent pas communiquer ensemble en utilisant leurs adresses IP ; elles doivent communiquer avec les autres par le routage de leurs adresses IP publiques.

Voir une configuration typique du trafic invité ci dessous :

Typiquement, le serveur de gestion crée automatiquement un routeur virtuel pour chaque réseau. Un routeur virtuel est une machine virtuelle spéciale qui fonctionne sur les hôtes. Chaque routeur virtuel dans un réseau isolé à trois interfaces réseaux. Si plusieurs VLAN publics sont utilisés, le routeur aura plusieurs interfaces publiques. Son interface eth0 servira de passerelle pour le trafic invité et a comme adresse IP 10.1.1.1. Son interface eth1 est utilisée par le système pour configurer le routeur virtuel. Son interface eth2 a une adresse IP publique d’assignée pour le trafic publique. Si de multiples VLAN publics sont utilisés, le routeur aura plusieurs interfaces publiques.

Le routeur virtuel fournit le service DHCP qui va automatiquement assigner une adresse IP pour chaque VM invitée dans l’intervalle d’IP assignées au réseau. L’utilisateur peut manuellement reconfigurer les VMs invités pour adopter différentes adresses IP.

Le Source Nat est automatiquement configuré dans le routeur virtuel pour transférer le trafic sortant de toutes les VMs invitées.

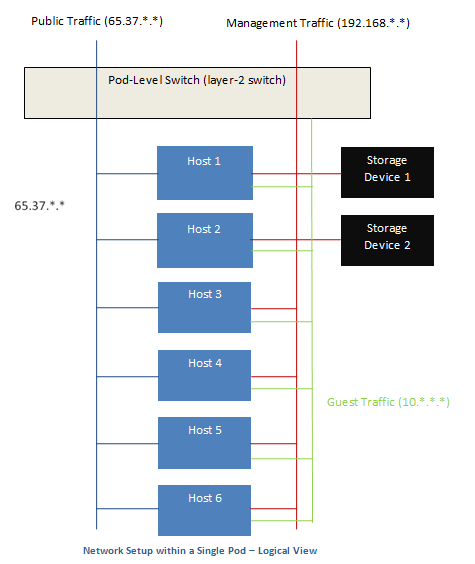

Le réseau dans un Pod¶

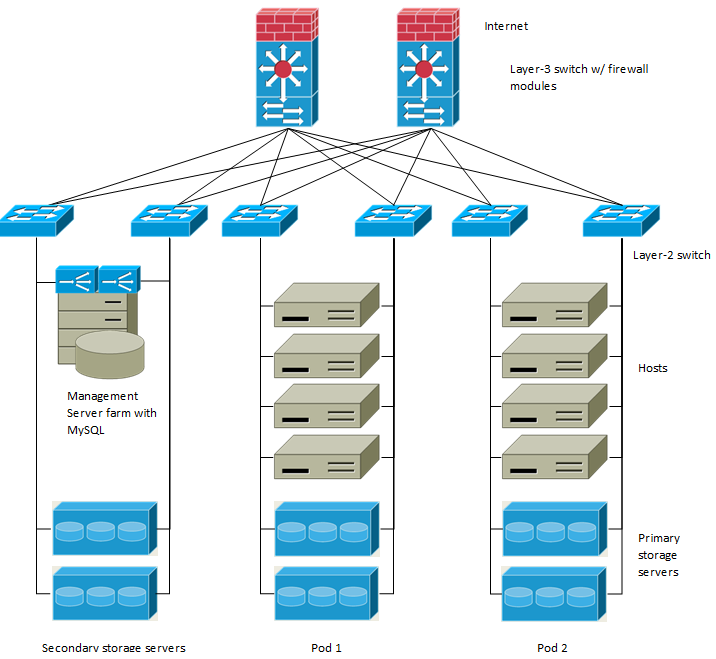

L’image suivante illustre la configuration du réseau au sein d’un seul pod; Les hôtes sont connectés à un commutateur de niveau pod. Au minimum, les hôtes devraient avoir un lien montant vers chaque commutateur. Les agrégats d’interfaces réseaux sont également supportés. Le commutateur du pod est une pair de commutateurs gigabits redondants avec des liens à 10G.

Les serveurs sont connectés comme ceci :

Les périphériques de stockages ne sont connectés qu’au réseau qui transporte le trafic de gestion.

Les hôtes sont connectés aux réseaux pour à la fois le trafic de gestion et le trafic publique.

Les hôtes sont aussi connectés à un ou plusieurs réseaux qui transportent le trafic invité.

Nous recommandons l’utilisation de plusieurs cartes physique Ethernet qui implémente chacune interface réseau comme une fabrique redondante de commutateur dans le but d’optimiser le débit et améliorer la fiabilité.

Le réseau dans une Zone¶

La figure suivante illustre la configuration du réseau au sein d’une seule zone.

Un parefeu pour le trafic de gestion opère dans le mode NAT. Le réseau assigne typiquement des adresses IP dans l’espace d’adressage du réseau privé de classe B 192.168.0.0/16. Chaque pod se voit assigné des adresses IP dans l’espace privé de classe C 192.168.*.0/24.

Chaque zone à son propre ensemble d’adresses IP publiques. Les adresses IP publiques depuis différentes zones ne doivent pas se chevaucher.

Configuration du réseau physique d’une zone basique¶

Dans un réseau basique, configurer le réseau physique est assez simple. Vous devez seulement configurer un réseau invité pour transporter le trafic généré par les VMs invitées. Quand vous ajouter pour la première fois une zone à CloudStack, vous configurer le réseau invité par les écrans Ajouter une zone.

Configuration du réseau physique d’une zone basique¶

A l’intérieur d’une zone qui utilise le réseau avancé, vous devez dire au serveur de gestion comment le réseau physique est configuré pour transporter différents types de trafics isolés.

Configurer le trafic invité dans une Zone Avancée¶

Ces étapes assume que vous êtes déjà connecté dans l’interface CloudStack. Pour configurer le réseau invité de base :

Dans le menu de gauche, choisir Infrastructure. Dans Zones, cliquer sur Voir Plus, puis cliquer sur la zone à laquelle vous voulez ajouter un réseau.

Cliquer sur l’onglet Réseau.

Cliquer sur Ajouter un réseau invité.

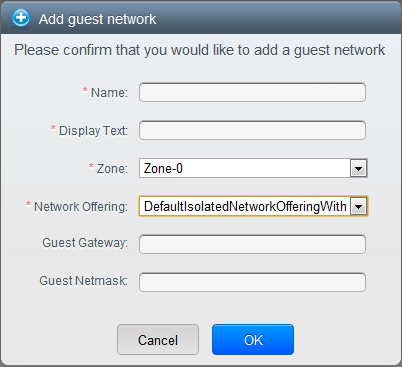

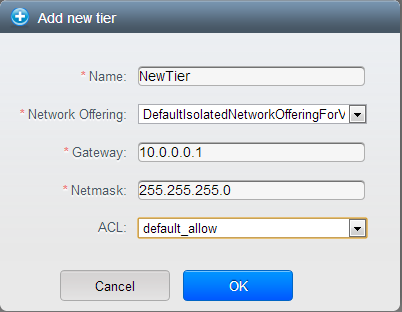

La fenêtre Ajouter un réseau invité est affichée :

Fournir l’information suivante :

Nom : Le nom du réseau. Cela sera visible de l’utilisateur.

Texte affiché: La description du réseau. Cela sera visible de l’utilisateur.

Zone : La zone pour laquelle vous êtes en train de configurer le réseau invité.

Offre réseau : Si l’administrateur a configuré plusieurs offres de réseau, sélectionner celui que vous voulez utiliser pour ce réseau.

Passerelle invitée : La passerelle que les invités devraient utiliser.

Masque de sous réseau invité : Le masque de sous réseau utilisé sur le sous réseau que les invités vont utiliser.

Cliquez sur OK.

Configurer le trafic public dans une Zone Avancée¶

Dans une zone qui utilise un réseau avancé, vous devez configurer au moins une plage d’adresses IP pour le trafic Internet.

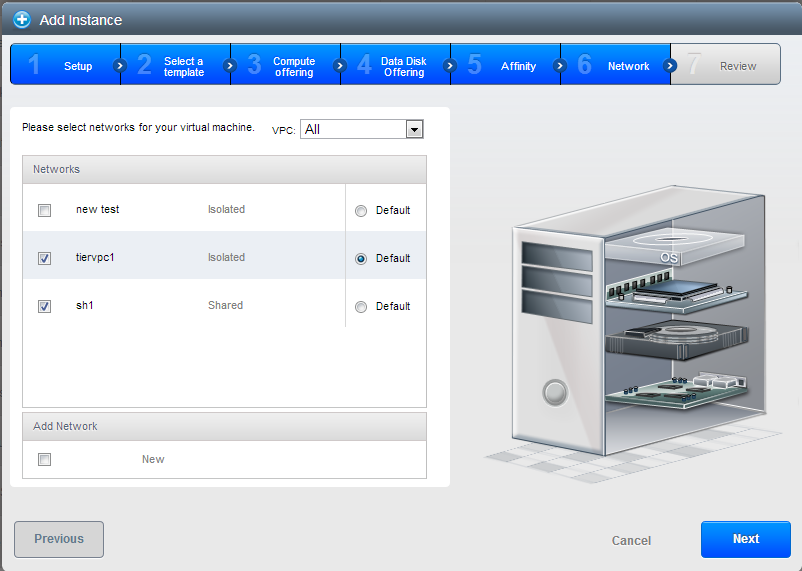

Utiliser plusieurs Réseaux d’Invités¶

Dans les zones qui utilisent le réseau avancé, des réseaux additionnels pour le trafic invité peuvent être ajouté à n’importe quel moment après l’installation initiale. Vous pouvez aussi personnaliser le nom de domaine associé avec le réseau en spécifiant un suffix DNS pour chaque réseau.

Les réseaux d’une VM sont définie à la création de la VM. Une VM ne peut pas ajouter ou supprimer des réseaux après qu’elle ait été créée, bien que l’utilisateur peut aller dans son inviter et supprimer l’adresse IP sur la carte réseau d’un réseau particulier.

Chaque VM a juste un réseau par défaut. La réponse du serveur DHCP du routeur virtuel configurera la passerelle par défaut de l’invité comme ça pour le réseau par défaut. Plusieurs réseaux qui ne sont pas par défaut peuvent être ajoutés à un invité en complément du seul réseau, ce qui nécessite le réseau par défaut. L’administrateur peut contrôler quels réseaux sont disponible comme réseau par défaut.

Des réseaux supplémentaire peuvent être disponible pour tous les comptes ou être assigné à un compte spécifique. Les réseaux qui sont disponibles à tous les comptes sont à l’échelle de la zone. Tout utilisateur avec un accès à la zone peut créer une VM avec un accès à ce réseau. Ces réseaux à l’échelle de la zone fournissent un peu ou pas du tout d’isolation entre les invités. Les réseaux qui sont assignés à un compte spécifique fournissent une isolation plus solide.

Ajouter un réseau invité supplémentaire¶

Se connecter à l’interface de CloudStack comme administrateur ou utilisateur final.

Dans la navigation à gauche, choisissez Réseau.

Cliquez sur Ajouter un réseau invité. Donnez les informations suivantes:

Nom : Le nom du réseau. Cela sera visible de l’utilisateur.

Texte affiché: La description du réseau. Cela sera visible de l’utilisateur.

Zone. Le nom de la zone à laquelle le réseau s’applique. Chaque zone est un domaine de diffusion, et par conséquent, chaque zone a une plage d’IP différente comme réseau d’invité. L’administrateur doit configurer la plage d’IP pour chaque zone.

Offre réseau : Si l’administrateur a configuré plusieurs offres de réseau, sélectionnez celle que vous voulez utiliser pour ce réseau.

Passerelle invitée : La passerelle que les invités devraient utiliser.

Masque de sous réseau invité : Le masque de sous réseau utilisé sur le sous réseau que les invités vont utiliser.

Cliquer sur Créer.

Reconfigurer les Réseaux dans les VMs¶

CloudStack vous offre la possibilité de déplacer des VMs d’un réseau à un autre et de reconfigurer son réseau. Vous pouvez retirer une VM d’un réseau et l’ajouter à un nouveau réseau. Vous pouvez aussi changer le réseau par défaut d’une machine virtuelle. Avec cette fonctionnalité, les charges d’un serveur traditionnel ou hybride peut être facilement adapté.

Cette fonctionnalité est supportée sur les hyperviseurs XenServer, VMware et KVM.

Prérequis¶

S’assurer que les vm-tools fonctionnent sur les VMs invités pour ajouter ou retirer les réseaux pour que cela fonctionne sur les hyperviseur VMware.

Ajouter un réseau¶

Se connecter à l’interface de CloudStack comme administrateur ou utilisateur final.

Sur la gauche, cliquez sur Instances

Choisir la VM avec laquelle vous voulez travailler.

Cliquer sur l’onglet Interface.

Cliquer sur Ajouter un réseau à une VM.

La boîte de dialogue Ajouter un réseau à une VM est affichée.

Dans la liste déroulante, sélectionner le réseau que vous aimeriez ajouter à cette VM.

Une nouvelle interface réseau est ajoutée pour ce réseau. Vous pouvez voir les détails suivants dans la page de l’interface :

- ID

Nom du réseau

- Type

Adresse IP

Passerelle

Masque de sous-réseau

Par défaut ?

CIDR (pour IPv6)

Supprimer un réseau¶

Se connecter à l’interface de CloudStack comme administrateur ou utilisateur final.

Sur la gauche, cliquez sur Instances

Choisir la VM avec laquelle vous voulez travailler.

Cliquer sur l’onglet Interface.

Repérer l’interface que vous voulez retirer.

Cliquer sur le bouton Supprimer une interface.

Cliquer sur Oui pour confirmer.

Sélectionner le réseau par défaut.¶

Se connecter à l’interface de CloudStack comme administrateur ou utilisateur final.

Sur la gauche, cliquez sur Instances

Choisir la VM avec laquelle vous voulez travailler.

Cliquer sur l’onglet Interface.

Repérer l’interface avec laquelle vous voulez travailler.

Cliquer sur le bouton Définir une interface par défaut.

.

.Cliquer sur Oui pour confirmer.

Changer l’offre de réseau pour un réseau invités.¶

Un utilisateur ou un administrateur peut changer l’offre de réseau qui est associée avec un réseau d’invité existant.

Se connecter à l’interface de CloudStack comme administrateur ou utilisateur final.

Si vous êtes en train de changer d’une offre de réseau qui utilise le routeur virtuel CloudStack vers une qui utilise des périphériques externes comme fournisseurs de services réseaux, vous devez d’abord stopper toutes les VMs de ce réseau.

Dans la navigation à gauche, choisissez Réseau.

Cliquer sur le nom du réseau que vous voulez modifier.

Dans l’onglet Détails, cliquer sur Editer.

Dans Offre de Réseau, choisir la nouvelle offre de réseau, puis cliquer sur Appliquer.

Une invite est affichée demandant si vous voulez conserver le CIDR existant. Ceci vous permet de savoir que si vous changer l’offre de réseau, le CIDR sera réaffecté.

Si vous évoluez entre un routeur virtuel comme fournisseur et un périphérique réseau externe comme fournisseur, accepter le changement du CIDR pour continuer en cliquant sur Oui.

Attendre que la mise à jour soit finie. Ne pas essayer de redémarrer les VMs tant que le changement du réseau ne soit pas fini.

Si vous avez stoppé des VMs, redémarrer les.

La réservation d’IP dans les réseaux isolés invité.¶

Dans les réseaux d’invités isolés, une partie de l’espace d’adresse IP invité peut être réservée aux VM non CloudStack ou aux serveurs physiques. Pour ce faire, vous configurez une plage d’adresses IP réservées en spécifiant le CIDR lorsqu’un réseau invité est dans l’état Implémenté. Si vos clients souhaitent disposer de VM non contrôlées par CloudStack ou de serveurs physiques sur le même réseau, ils peuvent partager une partie de l’espace d’adressage IP qui est normalement fournie au réseau invité.

Dans une zone Avancée, une plage d’adresses IP ou un CIDR est affecté à un réseau lorsque celui-ci est défini. Le routeur virtuel CloudStack agit comme serveur DHCP et utilise le CIDR pour attribuer des adresses IP aux machines virtuelles invitées. Si vous décidez de réserver le CIDR à des fins autres que CloudStack, vous pouvez spécifier une partie de la plage d’adresses IP ou le CIDR qui ne devrait être attribuée que par le service DHCP du routeur virtuel aux machines virtuelles invitées créées dans CloudStack. Les adresses IP restantes de ce réseau sont appelées Plage d’IP Réservée. Lorsque la réservation d’IP est configurée, l’administrateur peut ajouter des machines virtuelles ou des serveurs physiques qui ne font pas partie de CloudStack au même réseau et leur attribuer les adresses IP réservées. Les VM invitées CloudStack ne peuvent plus acquérir d’IP de cette plage d’IP réservée.

Considérations sur la réservation d’IP¶

Prenez en compte ce qui suit avant de réserver une plage d’IP pour les machines externes à CloudStack :

La réservation IP est prise en charge uniquement dans les réseaux isolés.

La réservation IP ne peut être appliquée que lorsque le réseau est dans l’état Implementé.

Aucune réservation d’IP n’est effectuée par défaut.

Le CIDR des VM Invités que vous spécifiez doit être un sous-réseau du CIDR du réseau.

Spécifiez un CIDR de VM Invités valide. La réservation d’IP n’est appliquée que si aucune IP active n’existe à l’extérieur du CIDR des VM invités.

Vous ne pouvez pas appliquer une réservation d’IP si une machine virtuelle s’est vue allouer une adresse IP se trouvant en dehors du CIDR des VM Invités.

Pour réinitialiser une réservation d’IP existante, appliquez la réservation IP en spécifiant la valeur du réseau CIDR dans le champ CIDR.

Par exemple, le tableau suivant décris trois scénarios de création de réseau invité :

Cas

CIDR CIDR du réseau

Interval d’IP réservées pour les VMs Non-CloudStack

Description 1 10.1.1.0/24 Aucun

Aucun

Aucune réservation d’IP.

2 10.1.1.0/26 10.1.1.0/24 10.1.1.64 à 10.1.1.254

La réservation d’IP est configurée par l’API UpdateNetwork avec guestvmcidr=10.1.1.0/26 ou saisir 10.1.1.0/26 dans le champ CIDR de l’interface utilisateur.

3 10.1.1.0/24 Aucun

Aucun

La suppression d’une réservation d’IP est effectuée par l’API UpdateNetwork avec guestvmcidr=10.1.1.0/24 ou saisir 10.1.1.0/24 dans le champ CIDR de l’interface utilisateur.

Limitations¶

La réservation d’IP n’est pas supportée si des IP actives sont trouvées à l’extérieur du CIDR des VM invités.

La mise à niveau d’une offre réseau qui provoque une modification de son CIDR (comme une mise à niveau d’une offre sans périphériques externes vers une avec un périphérique externe), fait que la réservation d’IP devient nulle, le cas échéant. Reconfigurez la réservation d’IP dans le nouveau réseau ré-implémenté.

Recommandations¶

Appliquez la Réservation d’IP à un réseau invité dès que l’état du réseau passe à Implementé. Si vous appliquez la réservation peu de temps après le déploiement de la première VM invitée, des conflits mineurs surviennent lors de l’application de la réservation.

Réserver un intervalle d’IP¶

Se connecter à l’interface de CloudStack comme administrateur ou utilisateur final.

Dans la navigation à gauche, choisissez Réseau.

Cliquer sur le nom du réseau que vous voulez modifier.

Dans l’onglet Détails, cliquer sur Editer.

Le champ CIDR devient éditable.

Dans CIDR, spécifier le CIDR des VM invités.

Cliquer sur appliquer.

Attendre que la mise à jour soit finie. Le CIDR du réseau et la plage d’IP réservée sont affichées dans la page de Détails.

Reserving Public IP Addresses and VLANs for Accounts¶

CloudStack provides you the ability to reserve a set of public IP addresses and VLANs exclusively for an account. During zone creation, you can continue defining a set of VLANs and multiple public IP ranges. This feature extends the functionality to enable you to dedicate a fixed set of VLANs and guest IP addresses for a tenant.

Note that if an account has consumed all the VLANs and IPs dedicated to it, the account can acquire two more resources from the system. CloudStack provides the root admin with two configuration parameter to modify this default behavior: use.system.public.ips and use.system.guest.vlans. These global parameters enable the root admin to disallow an account from acquiring public IPs and guest VLANs from the system, if the account has dedicated resources and these dedicated resources have all been consumed. Both these configurations are configurable at the account level.

This feature provides you the following capabilities:

Reserve a VLAN range and public IP address range from an Advanced zone and assign it to an account

Disassociate a VLAN and public IP address range from an account

View the number of public IP addresses allocated to an account

Check whether the required range is available and is conforms to account limits.

The maximum IPs per account limit cannot be superseded.

Dédier un intervalle d’adressses IP à un compte¶

Se connecter à l’interface de CloudStack comme administrateur

Dans la barre de navigation de gauche, cliquer sur Infrastructure.

Dans Zones, cliquer sur Voir toutes.

Choisir la zone avec laquelle vous voulez travailler.

Cliquer sur l’onglet Réseau.

Dans le noeud Public du diagramme, cliquer sur Configure.

Cliquer sur l’onglet intervalle IP.

You can either assign an existing IP range to an account, or create a new IP range and assign to an account.

Pour assigner un intervalle d’IP existant à un compte, effectuer les actions suivantes :

Localiser l’intervalle d’IP avec lequel vous voulez travailler.

Cliquer sur le bouton Ajouter un compte

.

.La boîte de dialogue Ajouter un compte est affichée.

Spécifier les informations suivantes :

- Account: The account to which you want to assign the IP address range.

- Domain: The domain associated with the account.

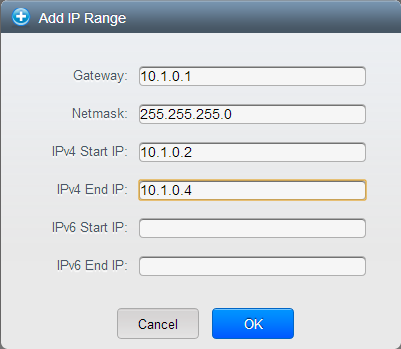

To create a new IP range and assign an account, perform the following:

Spécifier les informations suivantes :

Passerelle

Masque de sous-réseau

VLAN

IP de départ

IP de fin

Compte : Effectuer au choix :

Cliquer sur Compte.

La page Ajouter un compte est affichée.

Spécifier les informations suivantes :

- Account: The account to which you want to assign an IP address range.

- Domain: The domain associated with the account.

Cliquez sur OK.

Cliquer sur Ajouter.

Dédier des plages de VLAN à un compte¶

After the CloudStack Management Server is installed, log in to the CloudStack UI as administrator.

Dans la barre de navigation de gauche, cliquer sur Infrastructure.

Dans Zones, cliquer sur Voir toutes.

Choisir la zone avec laquelle vous voulez travailler.

Cliquer sur l’onglet Réseau.

Dans le noeud Invité du diagramme, cliquer sur Configurer.

Select the Dedicated VLAN Ranges tab.

Cliquersur Dédié un intervalle de VLAN

The Dedicate VLAN Range dialog is displayed.

Spécifier les informations suivantes :

- VLAN Range: The VLAN range that you want to assign to an account.

- Account: The account to which you want to assign the selected VLAN range.

- Domain: The domain associated with the account.

Configurer plusieurs adresses IP sur une seule interface réseau.¶

CloudStack offre la possibilité d’associer plusieurs adresses IP privées par interface NIC sur les VM clients. En plus de l’IP primaire, vous pouvez affecter des adresses IP supplémentaires à l’interface NIC de la VM invitée. Cette fonctionnalité est prise en charge sur toutes les configurations réseau : Basique, Avancée et VPC. Les services de Groupes de sécurité, de NAT statique et de transfert de port sont pris en charge sur ces IP supplémentaires.

Comme toujours, vous pouvez spécifier une IP à partir du sous-réseau invité ; si elle n’est pas spécifiée, une IP est automatiquement récupérée à partir du sous-réseau VM invité. Vous pouvez afficher les IP associées à chaque NIC de la VM invité sur l’interface utilisateur. Vous pouvez appliquer du NAT sur ces IP supplémentaires de l’invité en utilisant l’option de configuration réseau dans l’interface utilisateur CloudStack. Vous devez spécifier la carte réseau à laquelle l’adresse IP doit être associée.

Cette fonctionnalité est supportée sur les hyperviseurs XenServer, KVM et VMware. Notez que les groupes de sécurité dans les zones Basiques ne sont pas supportés sur VMware.

Cas d’usages¶

Les exemples suivants sont des cas d’usages :

Les périphériques réseaux, comme les pare-feu ou les répartiteurs de charge, fonctionnent généralement mieux lorsqu’ils ont accès à plusieurs adresses IP sur l’interface réseau.

Déplacer des adresses IP privées entre interfaces ou instances. Les applications qui sont liées à des adresses IP spécifiques peuvent être déplacées entre les instances.

Héberger plusieurs sites webs SSL sur une seule instance. Vous pouvez installer plusieurs certificats sur une seule instance, chacun associé avec une adresse IP distincte.

Lignes directrices¶

Pour éviter des conflits IP, configurer différents sous-réseaux lorsque plusieurs réseaux sont connectés à la même VM.

Assigner des IPs additionnelles à une VM¶

Se connecter à l’interface CloudStack.

Dans la barre de navigation de gauche, cliquer sur Instances.

Cliquez sur le nom de l’instance avec laquelle vous souhaitez travailler.

Dans l’onglet Détails, cliquer sur Interfaces.

Cliquer sur Voir les IPs secondaires.

Cliquez sur Obtenir une nouvelle adresse IP, et cliquez sur Oui dans la boîte de dialogue de confirmation.

Vous devez configurer l’IP sur l’interface de la VM invitée manuellement. CloudStack ne va pas automatiquement configurer l’IP acquise sur la VM. Assurez vous que la configuration de l’adresse IP soit persistante après le redémarrage.

Au bout de quelques instants, la nouvelle adresse IP devrait apparaître dans l’état Allouée. Vous pouvez maintenant utiliser l’adresse IP pour la redirection de port ou les règles de NAT statiques.

Changements de services de redirection de port et de StaticNAT¶

Étant donné que plusieurs IP peuvent être associées par carte réseau, vous êtes autorisé à sélectionner l’adresse IP désirée pour les services Port Forwarding et StaticNAT. La valeur par défaut est l’adresse IP principale. Pour activer cette fonctionnalité, un paramètre optionnel supplémentaire ‘vmguestip’ est ajouté aux API du port forwarding et du StaticNAT (enableStaticNat, createIpForwardingRule) pour indiquer sur quelle adresse IP le NAT doit être configuré. Si vmguestip est passé, le NAT est configuré sur l’IP privée spécifiée de la VM. Si elle n’est pas passée, le NAT est configuré sur l’adresse IP principale de la VM.

A propos des intervalles IP multiples¶

Note

Cette fonctionnalité ne peut être implémentée que sur les adresses IPv4.

CloudStack offre la flexibilité d’ajouter des plages d’IP d’invité de différents sous-réseaux dans les zones Basiques et dans les zones Avancées avec groupes de sécurité. Pour les zones avancées avec groupes de sécurité, cela implique que plusieurs sous-réseaux puissent être ajoutés au même VLAN. Grâce à cette fonctionnalité, vous pourrez ajouter des plages d’adresses IP à partir du même sous-réseau ou à partir d’un autre lorsque les adresses IP sont épuisées. Cela permet au final d’utiliser un plus grand nombre de sous-réseaux et de réduire ainsi la charge de travail liée à la gestion des adresses. Pour prendre en charge cette fonctionnalité, la capacité de l’API `` createVlanIpRange`` est étendue pour ajouter des plages d’adresses IP à partir d’un autre sous-réseau.

Assurez-vous d’avoir manuellement configuré la passerelle du nouveau sous-réseau avant d’ajouter la plage d’IP. Notez que CloudStack supporte une seule passerelle par sous-réseau ; le chevauchement de réseau n’est pas actuellement pris en compte.

Utilisez l’API deleteVlanRange pour supprimer les plages IP. Cette opération échoue si une IP parmi celles de la plage de suppression est en cours d’utilisation. Si la plage de suppression contient l’adresse IP d’un serveur DHCP est en cours d’exécution, CloudStack acquiert une nouvelle adresse IP à partir du même sous-réseau. Si aucune adresse IP n’est disponible dans le sous-réseau, l’opération de suppression échoue.

Cette fonctionnalité est supportée sur les hyperviseurs XenServer, VMware et KVM.

A propos d’Elastic IP¶

Les adresses Elastic IP (EIP) sont les adresses IP associées à un compte et qui agissent comme des adresses IP statiques. Le propriétaire du compte a le contrôle complet sur les adresses IP Elastic qui appartiennent au compte. En tant que propriétaire d’un compte, vous pouvez allouer une IP élastique à une machine virtuelle de votre choix depuis la réserve d’EIP de votre compte. Plus tard, si nécessaire, vous pouvez réaffecter l’adresse IP à une machine virtuelle différente. Cette fonctionnalité est extrêmement utile lors de la défaillance d’une VM. Au lieu de remplacer la machine virtuelle qui est en panne, l’adresse IP peut être réaffectée à une nouvelle VM de votre compte.

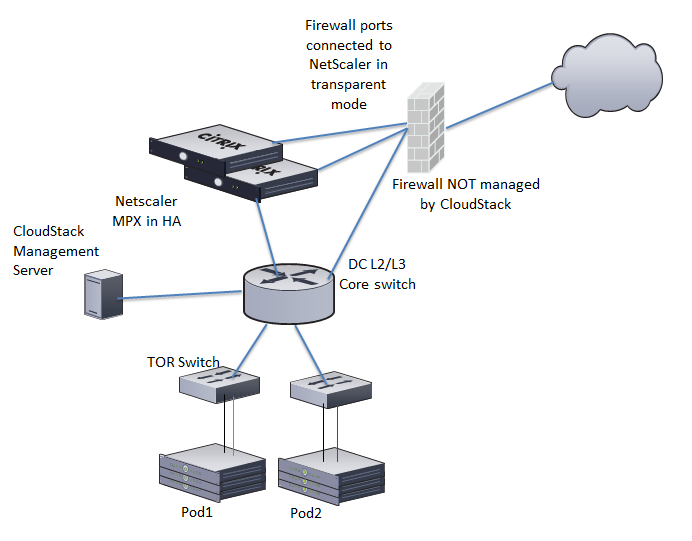

De manière similaire à une adresse IP publique, les adresses Elastic IP sont mappées à leurs adresses IP privées associées en utilisant du StaticNAT. Le service EIP est équipé du service StaticNAT (1:1) dans une zone basique avec EIP activé. L’offre réseau par défaut, DefaultSharedNetscalerEIPandELBNetworkOffering, fournit à votre réseau des services réseau EIP et ELB si un périphérique NetScaler est déployé dans votre zone. Considérez l’illustration suivante pour plus de détails.

Dans l’illustration, une appliance NetScaler est le point d’entrée ou de sortie par défaut pour les instances CloudStack et le pare-feu est l’entrée ou le point de sortie par défaut pour le reste du centre de données. Le Netscaler fournit des services de LB et un service staticNAT aux réseaux invités. Le trafic invité dans les pods et le serveur d’administration se trouvent sur différents sous-réseaux / VLAN. Le routage basé sur les stratégies dans le coeur de réseau du centre de données envoie le trafic public via le NetScaler, tandis que le reste du centre de données passe par le pare-feu.

Le workflow de l’EIP est le suivant :

Lorsqu’une VM utilisateur est déployée, une IP publique est automatiquement acquise depuis la réserve d’IPs publiques configurée dans la zone. Cette IP appartient au compte de la VM.

Chaque VM va avoir sa propre IP privée. Lorsque la VM de l’utilisateur démarre, le Static Nat est provisionné sur le périphérique NetScaler en utilisant des règles d’Inbound Network Address Translation (INAT) et de Reverse NAT (RNAT) entre l’IP publique et l’IP privée

Note

L’Inbound NAT (INAT - NAT entrant) est un type de NAT pris en charge par les NetScaler, dans lequel l’adresse IP de destination est remplacée dans les paquets provenant du réseau public, comme Internet, par l’adresse IP privée d’une machine virtuelle dans le réseau privé. Le Reverse NAT (RNAT) est un type de NAT pris en charge par les NetScaler, dans lequel l’adresse IP source dans les paquets générés par une machine virtuelle dans le réseau privé est remplacée par l’adresse IP publique.

Cette adresse IP publique par défaut sera libérée dans deux cas :

Lorsque la VM est stoppée. Lorsque la VM redémarre, elle reçoit à nouveau une nouvelle IP publique, qui n’est pas nécessairement la même qui avait été initialement attribuée, depuis la réserve d’IP publiques.

L’utilisateur acquiert une IP public (Elastic IP). Cette IP publique est associée au compte, mais ne sera pas mappée à une IP privée. Toutefois, l’utilisateur peut activer le NAT statique pour associer cette adresse IP à l’adresse IP privée d’une machine virtuelle de son compte. La règle de NAT statique pour l’IP publique peut être désactivée à tout moment. Lorsque le NAT statique est désactivé, une nouvelle IP publique est allouée à partir de la réserve, qui n’est pas nécessairement la même ayant été allouée initialement.

Pour les déploiements où les IP publiques sont des ressources limitées, vous avez la possibilité de choisir de ne pas allouer une IP publique par défaut. Vous pouvez utiliser l’option Associer une IP publique pour activer ou désactiver l’affectation d’IP publique automatique dans les zones basiques ayant l’EIP activé. Si vous désactivez l’affectation d’IP publique automatique lors de la création d’une offre réseau, seule une adresse IP privée est affectée à une machine virtuelle lorsque la machine virtuelle est déployée avec cette offre réseau. Plus tard, l’utilisateur peut acquérir une adresse IP pour la VM et activer le NAT statique.

Pour plus d’informations sur l’option d’association d’IP publique, consulter “Créer une nouvelle offre de réseau”.

Note

La fonctionnalité d’association d’IP publique est conçue uniquement pour les VM utilisateur. Les VM systèmes continuent d’obtenir à la fois une adresse IP publique et une privée par défaut, sans tenir compte de la configuration de l’offre réseau.

Les nouveaux déploiements qui utilisent l’offre de réseau partagé par défaut avec services EIP et ELB pour créer un réseau partagé dans une zone basique vont continuer d’allouer des IP publiques à chaque VM utilisateur.

IPs portable¶

A propos des IP portables¶

Les IP portables dans CloudStack sont des réserves d’adresses IP de niveau région, qui sont élastiques de nature, qui peuvent être transférées entre zones géographiquement séparées. En tant qu’administrateur, vous pouvez provisionner un ensemble d’IP publiques portables au niveau de la région et les rendre disponibles pour utilisation par les utilisateurs. Les utilisateurs peuvent acquérir des adresses IP portables si l’administrateur a fourni des IP portables au niveau de la région dont ils font partie. Ces IP peuvent être utilisées pour n’importe quel service dans une zone avancée. Vous pouvez également utiliser des adresses IP portables pour les services EIP dans les zones basiques.

Les principales caractéristiques d’une IP portable sont :

L’IP est attribuée de manière statique

Il n’est pas nécessaire d’associer une IP à un réseau

L’association IP est transférable entre les réseaux

Les IP sont transférables entre à la fois les zones basiques et les zones avancées.

Une IP est transférable entre VPC et les réseaux partagés ou isolés non-VPC

Le transfert d’IP portable n’est disponible que pour le NAT static.

Lignes directrices¶

Avant de transférer à un autre réseau, assurez vous qu’aucune règle réseau (Pare-feu, Static Nat, Redirection de port, etc.) n’existe sur cette IP portable.

Configuration des IP portables¶

Se connecter à l’interface de CloudStack comme administrateur ou utilisateur final.

Dans la barre de navigation de gauche, cliquer sur Régions.

Choisir les régions avec lesquelles vous voulez travailler.

Cliquer sur voir l’IP Portable.

Cliquer sur la plage d’IP portable

La fenêtre Ajouter une plage d’IP portable s’affiche.

Spécifier les informations suivantes :

IP de début, IP de fin : Une plage d’adresses IP qui sera accessible depuis Internet et sera associée aux VM invités. Saisir la première et la dernière adresse qui définissent une plage que CloudStack peut assigner aux VM invités.

Passerelle : La passerelle à utiliser pour les adresses IP portables que vous êtes en train de configurer.

Masque de sous-réseau : Le masque de sous-réseau associé avec la plage d’IP portable.

VLAN : Le VLAN qui va être utilisé pour le trafic public.

Cliquez sur OK.

Aquérir une IP portable¶

Se connecter à l’interface de CloudStack comme administrateur ou utilisateur final.

Dans la navigation à gauche, choisissez Réseau.

Cliquez sur le nom du réseau avec lequel vous souhaitez travailler.

Cliquez sur Voir les adresses IP.

Cliquer sur Acquérir une nouvelle IP.

La fenêtre Acquérir une nouvelle IP est affichée.

Spécifier si vous voulez une IP transverse à la zone ou non.

Cliquer sur Oui dans la boite de dialogue de confirmation.

Après quelques instants, la nouvelle adresse IP devrait apparaître avec l’état Allouée. Vous pouvez utiliser l’adresse IP dans la redirection de port ou les règles de NATage statiques.

Transférer une IP Portable¶

Une IP peut être transférée depuis un réseau vers un autre seulement si le Static NAT est activé. Cependant, lorsqu’une IP portable est associée à un réseau, vous pouvez l’utiliser pour n’importe quel service du réseau.

Pour transférer une IP portable entre des réseaux, exécutez l’API suivante :

http://localhost:8096/client/api?command=enableStaticNat&response=json&ipaddressid=a4bc37b2-4b4e-461d-9a62-b66414618e36&virtualmachineid=a242c476-ef37-441e-9c7b-b303e2a9cb4f&networkid=6e7cd8d1-d1ba-4c35-bdaf-333354cbd49810

Remplacez l’UUID par l’UUID approprié. Par exemple, si vous souhaitez transférer une adresse IP portable vers le réseau X et une VM Y dans un réseau, exécutez les opérations suivantes:

http://localhost:8096/client/api?command=enableStaticNat&response=json&ipaddressid=a4bc37b2-4b4e-461d-9a62-b66414618e36&virtualmachineid=Y&networkid=X

Isolation in Advanced Zone Using Private VLAN¶

Isolation of guest traffic in shared networks can be achieved by using Private VLANs (PVLAN). PVLANs provide Layer 2 isolation between ports within the same VLAN. In a PVLAN-enabled shared network, a user VM cannot reach other user VM though they can reach the DHCP server and gateway, this would in turn allow users to control traffic within a network and help them deploy multiple applications without communication between application as well as prevent communication with other users’ VMs.

- Isolate VMs in a shared networks by using Private VLANs.

Supportée par les hyperviseurs KVM, XenServer et VMware.

- PVLAN-enabled shared network can be a part of multiple networks of a guest VM.

A propos des VLAN Privés¶

In an Ethernet switch, a VLAN is a broadcast domain where hosts can establish direct communication with each another at Layer 2. Private VLAN is designed as an extension of VLAN standard to add further segmentation of the logical broadcast domain. A regular VLAN is a single broadcast domain, whereas a private VLAN partitions a larger VLAN broadcast domain into smaller sub-domains. A sub-domain is represented by a pair of VLANs: a Primary VLAN and a Secondary VLAN. The original VLAN that is being divided into smaller groups is called Primary, which implies that all VLAN pairs in a private VLAN share the same Primary VLAN. All the secondary VLANs exist only inside the Primary. Each Secondary VLAN has a specific VLAN ID associated to it, which differentiates one sub-domain from another.

Three types of ports exist in a private VLAN domain, which essentially determine the behaviour of the participating hosts. Each ports will have its own unique set of rules, which regulate a connected host’s ability to communicate with other connected host within the same private VLAN domain. Configure each host that is part of a PVLAN pair can be by using one of these three port designation:

- Promiscuous: A promiscuous port can communicate with all the interfaces, including the community and isolated host ports that belong to the secondary VLANs. In Promiscuous mode, hosts are connected to promiscuous ports and are able to communicate directly with resources on both primary and secondary VLAN. Routers, DHCP servers, and other trusted devices are typically attached to promiscuous ports.

- Isolated VLANs: The ports within an isolated VLAN cannot communicate with each other at the layer-2 level. The hosts that are connected to Isolated ports can directly communicate only with the Promiscuous resources. If your customer device needs to have access only to a gateway router, attach it to an isolated port.

- Community VLANs: The ports within a community VLAN can communicate with each other and with the promiscuous ports, but they cannot communicate with the ports in other communities at the layer-2 level. In a Community mode, direct communication is permitted only with the hosts in the same community and those that are connected to the Primary PVLAN in promiscuous mode. If your customer has two devices that need to be isolated from other customers’ devices, but to be able to communicate among themselves, deploy them in community ports.

For further reading:

Prérequis¶

Use a PVLAN supported switch.

See Private VLAN Catalyst Switch Support Matrix for more information.

All the layer 2 switches, which are PVLAN-aware, are connected to each other, and one of them is connected to a router. All the ports connected to the host would be configured in trunk mode. Open Management VLAN, Primary VLAN (public) and Secondary Isolated VLAN ports. Configure the switch port connected to the router in PVLAN promiscuous trunk mode, which would translate an isolated VLAN to primary VLAN for the PVLAN-unaware router.

Note that only Cisco Catalyst 4500 has the PVLAN promiscuous trunk mode to connect both normal VLAN and PVLAN to a PVLAN-unaware switch. For the other Catalyst PVLAN support switch, connect the switch to upper switch by using cables, one each for a PVLAN pair.

Configure private VLAN on your physical switches out-of-band.

Before you use PVLAN on XenServer and KVM, enable Open vSwitch (OVS).

Note

OVS on XenServer and KVM does not support PVLAN natively. Therefore, CloudStack managed to simulate PVLAN on OVS for XenServer and KVM by modifying the flow table.

Creating a PVLAN-Enabled Guest Network¶

Se connecter à l’interface de CloudStack comme administrateur

Choisissez Infrastructure dans le panneau de navigation à gauche.

Dans zones, cliquez sur Voir tout.

Cliquer sur la zone à laquelle vous voulez ajouter un réseau invité.

Cliquer sur l’onglet Réseau.

Cliquer sur le réseau physique avec lequel vous voulez travailler.

Sur le noeud Invité du diagramme, cliquer sur Configurer.

Cliquer sur l’onglet Réseau.

Cliquer sur Ajouter un réseau invité.

La fenêtre Ajouter un réseau invité est affichée :

Spécifier les informations suivantes :

Nom : Le nom du réseau. Cela sera visible de l’utilisateur.

Description : La description courte du réseau qui peut être affichée aux utilisateurs

ID VLAN : L’ID unique du VLAN.

Secondary Isolated VLAN ID: The unique ID of the Secondary Isolated VLAN.

For the description on Secondary Isolated VLAN, see About Private VLAN”.

Portée : Les portées possibles sont Domaine, Compte, Projet et Tous.

Domaine : Sélectionner Domaine limite la partée de ce réseau invité au domaine que vous spécifiez. Le réseau ne sera pas disponible pour les autres domaines.Si vous sélectionnez Accès Sous Domaine, le réseau invité est disponible à tous les sous domaines au sein du domaine sélectionné.

Compte : Le compte pour lequel le réseau invité est créé. Vous devez spécifier le domaine auquel appartient le compte.

Projet : Le projet pour lequel le réseau invité est créé. Vous devez spécifier le domaine auquel le projet appartient.

Tous : Le réseau invité est disponible pour tous les domaines, comptes, projets au sein de la zone sélectionnée.

Offre réseau : Si l’administrateur a configuré plusieurs offres de réseau, sélectionnez celle que vous voulez utiliser pour ce réseau.

Passerelle : La passerelle que les invités devraient utiliser.

Masque de sous réseau : Le masque de sous réseau du réseau que les utilisateurs vont utiliser.

Plage IP : Une plage d’adresses IP qui sont accessibles depuis l’Internet est qui sont assignées aux VMs invitées.

Domaine Réseau : Un suffixe DNS personnalisé au niveau du réseau. Si vous voulez assigner un nom de domaine spécial au réseau des VM invitées, spécifier un suffixe DNS.

Cliquer OK pour confirmer.

Groupes de sécurités¶

A propos des groupes de sécurité¶

Security groups provide a way to isolate traffic to VMs. A security group is a group of VMs that filter their incoming and outgoing traffic according to a set of rules, called ingress and egress rules. These rules filter network traffic according to the IP address that is attempting to communicate with the VM. Security groups are particularly useful in zones that use basic networking, because there is a single guest network for all guest VMs. In advanced zones, security groups are supported only on the KVM hypervisor.

Note

In a zone that uses advanced networking, you can instead define multiple guest networks to isolate traffic to VMs.

Each CloudStack account comes with a default security group that denies all inbound traffic and allows all outbound traffic. The default security group can be modified so that all new VMs inherit some other desired set of rules.

Any CloudStack user can set up any number of additional security groups. When a new VM is launched, it is assigned to the default security group unless another user-defined security group is specified. A VM can be a member of any number of security groups. Once a VM is assigned to a security group, it remains in that group for its entire lifetime; you can not move a running VM from one security group to another.

You can modify a security group by deleting or adding any number of ingress and egress rules. When you do, the new rules apply to all VMs in the group, whether running or stopped.

If no ingress rules are specified, then no traffic will be allowed in, except for responses to any traffic that has been allowed out through an egress rule.

Ajouter un groupe de sécurité¶

Un utilisateur ou un administrateur peut définir un nouveau groupe de sécurité.

Se connecter à l’interface de CloudStack comme administrateur ou utilisateur final.

Dans la navigation à gauche, choisissez Réseau.

Dans la zone de sélection, choisir Groupes de Sécurité.

Cliquer sur Ajouter un groupe de sécurité.

Fournir un nom et une description.

Cliquez sur OK.

Le nouveau groupe de sécurité apparaît dans l’onglet Détails des Groupes de Sécurité.

Pour rendre le groupe de sécurité utile, continuez par Ajouter des règles Ingress et Egress à un groupe de sécurité.

Groupes de Sécurité dans les Zones Avancées (KVM uniquement)¶

CloudStack provides the ability to use security groups to provide isolation between guests on a single shared, zone-wide network in an advanced zone where KVM is the hypervisor. Using security groups in advanced zones rather than multiple VLANs allows a greater range of options for setting up guest isolation in a cloud.

Limitations¶

Les éléments suivants ne sont pas pris en charge pour cette fonctionnalité :

Deux plages d’IP avec le même VLAN et une passerelle ou masque de réseau différent dans un réseau partagé avec groupes de sécurité.

Deux plages d’IP avec le même VLAN et une passerelle ou un masque de réseau différent dans des réseaux partagés spécifiques à un compte.

Plusieurs plages de VLAN dans un réseau partagé avec groupes de sécurité.

Plusieurs plages de VLAN dans des réseaux partagés spécifiques à un compte.

Les groupes de sécurité doivent être activés dans la zone pour que cette fonctionnalité soit utilisée.

Activer les groupes de sécurités.¶

In order for security groups to function in a zone, the security groups feature must first be enabled for the zone. The administrator can do this when creating a new zone, by selecting a network offering that includes security groups. The procedure is described in Basic Zone Configuration in the Advanced Installation Guide. The administrator can not enable security groups for an existing zone, only when creating a new zone.

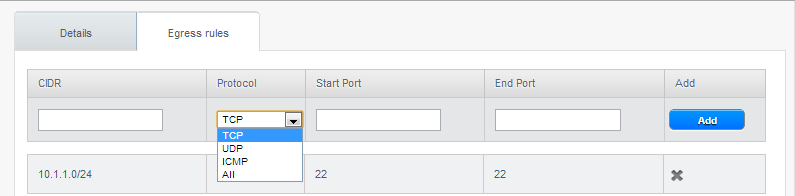

Ajout de règles Ingress et Egress à un Groupe de Sécurité¶

Se connecter à l’interface de CloudStack comme administrateur ou utilisateur final.

Dans la navigation à gauche, choisissez Réseau.

Dans la liste de choix, choisir Groupes de sécurité puis cliquer sur le groupe de sécurité désiré.

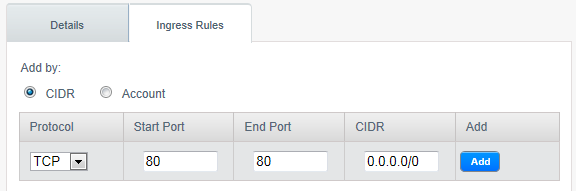

To add an ingress rule, click the Ingress Rules tab and fill out the following fields to specify what network traffic is allowed into VM instances in this security group. If no ingress rules are specified, then no traffic will be allowed in, except for responses to any traffic that has been allowed out through an egress rule.

- Add by CIDR/Account. Indicate whether the source of the traffic will be defined by IP address (CIDR) or an existing security group in a CloudStack account (Account). Choose Account if you want to allow incoming traffic from all VMs in another security group

- Protocol. The networking protocol that sources will use to send traffic to the security group. TCP and UDP are typically used for data exchange and end-user communications. ICMP is typically used to send error messages or network monitoring data.

- Start Port, End Port. (TCP, UDP only) A range of listening ports that are the destination for the incoming traffic. If you are opening a single port, use the same number in both fields.

- ICMP Type, ICMP Code. (ICMP only) The type of message and error code that will be accepted.

- CIDR. (Add by CIDR only) To accept only traffic from IP addresses within a particular address block, enter a CIDR or a comma-separated list of CIDRs. The CIDR is the base IP address of the incoming traffic. For example, 192.168.0.0/22. To allow all CIDRs, set to 0.0.0.0/0.

- Account, Security Group. (Add by Account only) To accept only traffic from another security group, enter the CloudStack account and name of a security group that has already been defined in that account. To allow traffic between VMs within the security group you are editing now, enter the same name you used in step 7.

L’exemple qui suit autorise l’accès HTTP entrant depuis n’importe où :

To add an egress rule, click the Egress Rules tab and fill out the following fields to specify what type of traffic is allowed to be sent out of VM instances in this security group. If no egress rules are specified, then all traffic will be allowed out. Once egress rules are specified, the following types of traffic are allowed out: traffic specified in egress rules; queries to DNS and DHCP servers; and responses to any traffic that has been allowed in through an ingress rule

- Add by CIDR/Account. Indicate whether the destination of the traffic will be defined by IP address (CIDR) or an existing security group in a CloudStack account (Account). Choose Account if you want to allow outgoing traffic to all VMs in another security group.

- Protocol. The networking protocol that VMs will use to send outgoing traffic. TCP and UDP are typically used for data exchange and end-user communications. ICMP is typically used to send error messages or network monitoring data.

- Start Port, End Port. (TCP, UDP only) A range of listening ports that are the destination for the outgoing traffic. If you are opening a single port, use the same number in both fields.

- ICMP Type, ICMP Code. (ICMP only) The type of message and error code that will be sent

- CIDR. (Add by CIDR only) To send traffic only to IP addresses within a particular address block, enter a CIDR or a comma-separated list of CIDRs. The CIDR is the base IP address of the destination. For example, 192.168.0.0/22. To allow all CIDRs, set to 0.0.0.0/0.

- Account, Security Group. (Add by Account only) To allow traffic to be sent to another security group, enter the CloudStack account and name of a security group that has already been defined in that account. To allow traffic between VMs within the security group you are editing now, enter its name.

Cliquer sur Ajouter.

External Firewalls and Load Balancers¶

CloudStack is capable of replacing its Virtual Router with an external Juniper SRX device and an optional external NetScaler or F5 load balancer for gateway and load balancing services. In this case, the VMs use the SRX as their gateway.

About Using a NetScaler Load Balancer¶

Citrix NetScaler is supported as an external network element for load balancing in zones that use isolated networking in advanced zones. Set up an external load balancer when you want to provide load balancing through means other than CloudStack’s provided virtual router.

Note

In a Basic zone, load balancing service is supported only if Elastic IP or Elastic LB services are enabled.

When NetScaler load balancer is used to provide EIP or ELB services in a Basic zone, ensure that all guest VM traffic must enter and exit through the NetScaler device. When inbound traffic goes through the NetScaler device, traffic is routed by using the NAT protocol depending on the EIP/ELB configured on the public IP to the private IP. The traffic that is originated from the guest VMs usually goes through the layer 3 router. To ensure that outbound traffic goes through NetScaler device providing EIP/ELB, layer 3 router must have a policy-based routing. A policy-based route must be set up so that all traffic originated from the guest VM’s are directed to NetScaler device. This is required to ensure that the outbound traffic from the guest VM’s is routed to a public IP by using NAT.For more information on Elastic IP, see “About Elastic IP”.

The NetScaler can be set up in direct (outside the firewall) mode. It must be added before any load balancing rules are deployed on guest VMs in the zone.

The functional behavior of the NetScaler with CloudStack is the same as described in the CloudStack documentation for using an F5 external load balancer. The only exception is that the F5 supports routing domains, and NetScaler does not. NetScaler can not yet be used as a firewall.

To install and enable an external load balancer for CloudStack management, see External Guest Load Balancer Integration in the Installation Guide.

The Citrix NetScaler comes in three varieties. The following summarizes how these variants are treated in CloudStack.

MPX

- Physical appliance. Capable of deep packet inspection. Can act as application firewall and load balancer

- In advanced zones, load balancer functionality fully supported without limitation. In basic zones, static NAT, elastic IP (EIP), and elastic load balancing (ELB) are also provided.

VPX

- Virtual appliance. Can run as VM on XenServer, ESXi, and Hyper-V hypervisors. Same functionality as MPX

- Supported on ESXi and XenServer. Same functional support as for MPX. CloudStack will treat VPX and MPX as the same device type.

SDX

- Physical appliance. Can create multiple fully isolated VPX instances on a single appliance to support multi-tenant usage

- CloudStack will dynamically provision, configure, and manage the life cycle of VPX instances on the SDX. Provisioned instances are added into CloudStack automatically - no manual configuration by the administrator is required. Once a VPX instance is added into CloudStack, it is treated the same as a VPX on an ESXi host.

Configuring SNMP Community String on a RHEL Server¶

The SNMP Community string is similar to a user id or password that provides access to a network device, such as router. This string is sent along with all SNMP requests. If the community string is correct, the device responds with the requested information. If the community string is incorrect, the device discards the request and does not respond.

The NetScaler device uses SNMP to communicate with the VMs. You must install SNMP and configure SNMP Community string for a secure communication between the NetScaler device and the RHEL machine.

Ensure that you installed SNMP on RedHat. If not, run the following command:

yum install net-snmp-utils

Edit the /etc/snmp/snmpd.conf file to allow the SNMP polling from the NetScaler device.

Map the community name into a security name (local and mynetwork, depending on where the request is coming from):

Note

Use a strong password instead of public when you edit the following table.

# sec.name source community com2sec local localhost public com2sec mynetwork 0.0.0.0 public

Note

Setting to 0.0.0.0 allows all IPs to poll the NetScaler server.

Map the security names into group names:

# group.name sec.model sec.name group MyRWGroup v1 local group MyRWGroup v2c local group MyROGroup v1 mynetwork group MyROGroup v2c mynetwork

Create a view to allow the groups to have the permission to:

incl/excl subtree mask view all included .1

Grant access with different write permissions to the two groups to the view you created.

# context sec.model sec.level prefix read write notif access MyROGroup "" any noauth exact all none none access MyRWGroup "" any noauth exact all all all

Unblock SNMP in iptables.

iptables -A INPUT -p udp --dport 161 -j ACCEPT

Start the SNMP service:

service snmpd start

Ensure that the SNMP service is started automatically during the system startup:

chkconfig snmpd on

Initial Setup of External Firewalls and Load Balancers¶

When the first VM is created for a new account, CloudStack programs the external firewall and load balancer to work with the VM. The following objects are created on the firewall:

- A new logical interface to connect to the account’s private VLAN. The interface IP is always the first IP of the account’s private subnet (e.g. 10.1.1.1).

- A source NAT rule that forwards all outgoing traffic from the account’s private VLAN to the public Internet, using the account’s public IP address as the source address

- A firewall filter counter that measures the number of bytes of outgoing traffic for the account

The following objects are created on the load balancer:

- A new VLAN that matches the account’s provisioned Zone VLAN

- A self IP for the VLAN. This is always the second IP of the account’s private subnet (e.g. 10.1.1.2).

Ongoing Configuration of External Firewalls and Load Balancers¶

Additional user actions (e.g. setting a port forward) will cause further programming of the firewall and load balancer. A user may request additional public IP addresses and forward traffic received at these IPs to specific VMs. This is accomplished by enabling static NAT for a public IP address, assigning the IP to a VM, and specifying a set of protocols and port ranges to open. When a static NAT rule is created, CloudStack programs the zone’s external firewall with the following objects:

- A static NAT rule that maps the public IP address to the private IP address of a VM.

- A security policy that allows traffic within the set of protocols and port ranges that are specified.

- A firewall filter counter that measures the number of bytes of incoming traffic to the public IP.

The number of incoming and outgoing bytes through source NAT, static NAT, and load balancing rules is measured and saved on each external element. This data is collected on a regular basis and stored in the CloudStack database.

Règles de répartition de charge¶

A CloudStack user or administrator may create load balancing rules that balance traffic received at a public IP to one or more VMs. A user creates a rule, specifies an algorithm, and assigns the rule to a set of VMs.

Note

If you create load balancing rules while using a network service offering that includes an external load balancer device such as NetScaler, and later change the network service offering to one that uses the CloudStack virtual router, you must create a firewall rule on the virtual router for each of your existing load balancing rules so that they continue to function.

Ajouter une règle de répartition de charge¶

Se connecter à l’interface de CloudStack comme administrateur ou utilisateur final.

Dans la navigation à gauche, choisissez Réseau.

Click the name of the network where you want to load balance the traffic.

Cliquez sur Voir les adresses IP.

Click the IP address for which you want to create the rule, then click the Configuration tab.

In the Load Balancing node of the diagram, click View All.

In a Basic zone, you can also create a load balancing rule without acquiring or selecting an IP address. CloudStack internally assign an IP when you create the load balancing rule, which is listed in the IP Addresses page when the rule is created.

To do that, select the name of the network, then click Add Load Balancer tab. Continue with #7.

Remplissez les champs suivants:

- Name: A name for the load balancer rule.

- Public Port: The port receiving incoming traffic to be balanced.

- Private Port: The port that the VMs will use to receive the traffic.

- Algorithm: Choose the load balancing algorithm you want CloudStack to use. CloudStack supports a variety of well-known algorithms. If you are not familiar with these choices, you will find plenty of information about them on the Internet.

- Stickiness: (Optional) Click Configure and choose the algorithm for the stickiness policy. See Sticky Session Policies for Load Balancer Rules.

- AutoScale: Click Configure and complete the AutoScale configuration as explained in Configuring AutoScale.

- Health Check: (Optional; NetScaler load balancers only) Click

Configure and fill in the characteristics of the health check

policy. See Health Checks for Load Balancer Rules.

- Ping path (Optional): Sequence of destinations to which to send health check queries. Default: / (all).

- Response time (Optional): How long to wait for a response from the health check (2 - 60 seconds). Default: 5 seconds.

- Interval time (Optional): Amount of time between health checks (1 second - 5 minutes). Default value is set in the global configuration parameter lbrule_health check_time_interval.

- Healthy threshold (Optional): Number of consecutive health check successes that are required before declaring an instance healthy. Default: 2.

- Unhealthy threshold (Optional): Number of consecutive health check failures that are required before declaring an instance unhealthy. Default: 10.

Click Add VMs, then select two or more VMs that will divide the load of incoming traffic, and click Apply.

The new load balancer rule appears in the list. You can repeat these steps to add more load balancer rules for this IP address.

Sticky Session Policies for Load Balancer Rules¶

Sticky sessions are used in Web-based applications to ensure continued availability of information across the multiple requests in a user’s session. For example, if a shopper is filling a cart, you need to remember what has been purchased so far. The concept of “stickiness” is also referred to as persistence or maintaining state.

Any load balancer rule defined in CloudStack can have a stickiness policy. The policy consists of a name, stickiness method, and parameters. The parameters are name-value pairs or flags, which are defined by the load balancer vendor. The stickiness method could be load balancer-generated cookie, application-generated cookie, or source-based. In the source-based method, the source IP address is used to identify the user and locate the user’s stored data. In the other methods, cookies are used. The cookie generated by the load balancer or application is included in request and response URLs to create persistence. The cookie name can be specified by the administrator or automatically generated. A variety of options are provided to control the exact behavior of cookies, such as how they are generated and whether they are cached.

For the most up to date list of available stickiness methods, see the CloudStack UI or call listNetworks and check the SupportedStickinessMethods capability.

Health Checks for Load Balancer Rules¶

(NetScaler load balancer only; requires NetScaler version 10.0)

Health checks are used in load-balanced applications to ensure that requests are forwarded only to running, available services. When creating a load balancer rule, you can specify a health check policy. This is in addition to specifying the stickiness policy, algorithm, and other load balancer rule options. You can configure one health check policy per load balancer rule.

Any load balancer rule defined on a NetScaler load balancer in CloudStack can have a health check policy. The policy consists of a ping path, thresholds to define “healthy” and “unhealthy” states, health check frequency, and timeout wait interval.

When a health check policy is in effect, the load balancer will stop forwarding requests to any resources that are found to be unhealthy. If the resource later becomes available again, the periodic health check will discover it, and the resource will once again be added to the pool of resources that can receive requests from the load balancer. At any given time, the most recent result of the health check is displayed in the UI. For any VM that is attached to a load balancer rule with a health check configured, the state will be shown as UP or DOWN in the UI depending on the result of the most recent health check.

You can delete or modify existing health check policies.

To configure how often the health check is performed by default, use the global configuration setting healthcheck.update.interval (default value is 600 seconds). You can override this value for an individual health check policy.

For details on how to set a health check policy using the UI, see Ajouter une règle de répartition de charge.

Configuring AutoScale¶

AutoScaling allows you to scale your back-end services or application VMs up or down seamlessly and automatically according to the conditions you define. With AutoScaling enabled, you can ensure that the number of VMs you are using seamlessly scale up when demand increases, and automatically decreases when demand subsides. Thus it helps you save compute costs by terminating underused VMs automatically and launching new VMs when you need them, without the need for manual intervention.

NetScaler AutoScaling is designed to seamlessly launch or terminate VMs based on user-defined conditions. Conditions for triggering a scaleup or scaledown action can vary from a simple use case like monitoring the CPU usage of a server to a complex use case of monitoring a combination of server’s responsiveness and its CPU usage. For example, you can configure AutoScaling to launch an additional VM whenever CPU usage exceeds 80 percent for 15 minutes, or to remove a VM whenever CPU usage is less than 20 percent for 30 minutes.

CloudStack uses the NetScaler load balancer to monitor all aspects of a system’s health and work in unison with CloudStack to initiate scale-up or scale-down actions.

Note

AutoScale is supported on NetScaler Release 10 Build 74.4006.e and beyond.

Prérequis¶

Before you configure an AutoScale rule, consider the following:

Ensure that the necessary template is prepared before configuring AutoScale. When a VM is deployed by using a template and when it comes up, the application should be up and running.

Note

If the application is not running, the NetScaler device considers the VM as ineffective and continues provisioning the VMs unconditionally until the resource limit is exhausted.

Deploy the templates you prepared. Ensure that the applications come up on the first boot and is ready to take the traffic. Observe the time requires to deploy the template. Consider this time when you specify the quiet time while configuring AutoScale.

The AutoScale feature supports the SNMP counters that can be used to define conditions for taking scale up or scale down actions. To monitor the SNMP-based counter, ensure that the SNMP agent is installed in the template used for creating the AutoScale VMs, and the SNMP operations work with the configured SNMP community and port by using standard SNMP managers. For example, see “Configuring SNMP Community String on a RHELServer” to configure SNMP on a RHEL machine.

Ensure that the endpointe.url parameter present in the Global Settings is set to the Management Server API URL. For example,

http://10.102.102.22:8080/client/api. In a multi-node Management Server deployment, use the virtual IP address configured in the load balancer for the management server’s cluster. Additionally, ensure that the NetScaler device has access to this IP address to provide AutoScale support.If you update the endpointe.url, disable the AutoScale functionality of the load balancer rules in the system, then enable them back to reflect the changes. For more information see Updating an AutoScale Configuration.

If the API Key and Secret Key are regenerated for an AutoScale user, ensure that the AutoScale functionality of the load balancers that the user participates in are disabled and then enabled to reflect the configuration changes in the NetScaler.

In an advanced Zone, ensure that at least one VM should be present before configuring a load balancer rule with AutoScale. Having one VM in the network ensures that the network is in implemented state for configuring AutoScale.

Configuration¶

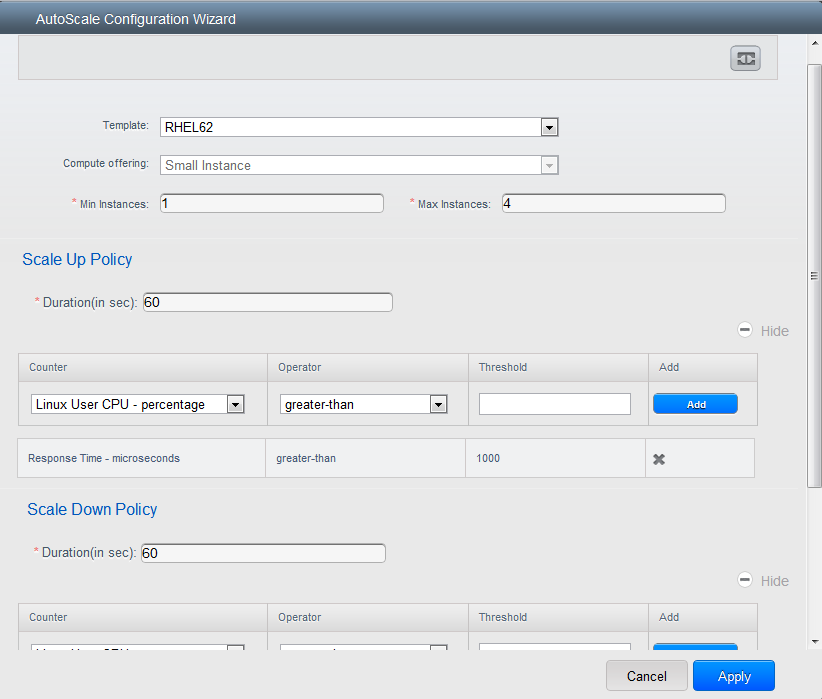

Spécifier les informations suivantes :

Template: A template consists of a base OS image and application. A template is used to provision the new instance of an application on a scaleup action. When a VM is deployed from a template, the VM can start taking the traffic from the load balancer without any admin intervention. For example, if the VM is deployed for a Web service, it should have the Web server running, the database connected, and so on.

Compute offering: A predefined set of virtual hardware attributes, including CPU speed, number of CPUs, and RAM size, that the user can select when creating a new virtual machine instance. Choose one of the compute offerings to be used while provisioning a VM instance as part of scaleup action.

Min Instance: The minimum number of active VM instances that is assigned to a load balancing rule. The active VM instances are the application instances that are up and serving the traffic, and are being load balanced. This parameter ensures that a load balancing rule has at least the configured number of active VM instances are available to serve the traffic.

Note

If an application, such as SAP, running on a VM instance is down for some reason, the VM is then not counted as part of Min Instance parameter, and the AutoScale feature initiates a scaleup action if the number of active VM instances is below the configured value. Similarly, when an application instance comes up from its earlier down state, this application instance is counted as part of the active instance count and the AutoScale process initiates a scaledown action when the active instance count breaches the Max instance value.

Max Instance: Maximum number of active VM instances that should be assigned toa load balancing rule. This parameter defines the upper limit of active VM instances that can be assigned to a load balancing rule.

Specifying a large value for the maximum instance parameter might result in provisioning large number of VM instances, which in turn leads to a single load balancing rule exhausting the VM instances limit specified at the account or domain level.

Note

If an application, such as SAP, running on a VM instance is down for some reason, the VM is not counted as part of Max Instance parameter. So there may be scenarios where the number of VMs provisioned for a scaleup action might be more than the configured Max Instance value. Once the application instances in the VMs are up from an earlier down state, the AutoScale feature starts aligning to the configured Max Instance value.

Specify the following scale-up and scale-down policies:

- Duration: The duration, in seconds, for which the conditions you specify must be true to trigger a scaleup action. The conditions defined should hold true for the entire duration you specify for an AutoScale action to be invoked.

- Counter: The performance counters expose the state of the monitored instances. By default, CloudStack offers four performance counters: Three SNMP counters and one NetScaler counter. The SNMP counters are Linux User CPU, Linux System CPU, and Linux CPU Idle. The NetScaler counter is ResponseTime. The root administrator can add additional counters into CloudStack by using the CloudStack API.

- Operator: The following five relational operators are supported in AutoScale feature: Greater than, Less than, Less than or equal to, Greater than or equal to, and Equal to.

- Threshold: Threshold value to be used for the counter. Once the counter defined above breaches the threshold value, the AutoScale feature initiates a scaleup or scaledown action.

- Add: Click Add to add the condition.

Additionally, if you want to configure the advanced settings, click Show advanced settings, and specify the following:

- Polling interval: Frequency in which the conditions, combination of counter, operator and threshold, are to be evaluated before taking a scale up or down action. The default polling interval is 30 seconds.

- Quiet Time: This is the cool down period after an AutoScale action is initiated. The time includes the time taken to complete provisioning a VM instance from its template and the time taken by an application to be ready to serve traffic. This quiet time allows the fleet to come up to a stable state before any action can take place. The default is 300 seconds.

- Destroy VM Grace Period: The duration in seconds, after a scaledown action is initiated, to wait before the VM is destroyed as part of scaledown action. This is to ensure graceful close of any pending sessions or transactions being served by the VM marked for destroy. The default is 120 seconds.

- Security Groups: Security groups provide a way to isolate traffic to the VM instances. A security group is a group of VMs that filter their incoming and outgoing traffic according to a set of rules, called ingress and egress rules. These rules filter network traffic according to the IP address that is attempting to communicate with the VM.

- Disk Offerings: A predefined set of disk size for primary data storage.

- SNMP Community: The SNMP community string to be used by the NetScaler device to query the configured counter value from the provisioned VM instances. Default is public.

- SNMP Port: The port number on which the SNMP agent that run on the provisioned VMs is listening. Default port is 161.

- User: This is the user that the NetScaler device use to invoke scaleup and scaledown API calls to the cloud. If no option is specified, the user who configures AutoScaling is applied. Specify another user name to override.

- Apply: Click Apply to create the AutoScale configuration.

Disabling and Enabling an AutoScale Configuration¶

If you want to perform any maintenance operation on the AutoScale VM

instances, disable the AutoScale configuration. When the AutoScale

configuration is disabled, no scaleup or scaledown action is performed.

You can use this downtime for the maintenance activities. To disable the

AutoScale configuration, click the Disable AutoScale  button.

button.

The button toggles between enable and disable, depending on whether

AutoScale is currently enabled or not. After the maintenance operations

are done, you can enable the AutoScale configuration back. To enable,

open the AutoScale configuration page again, then click the Enable

AutoScale  button.

button.

Updating an AutoScale Configuration¶

You can update the various parameters and add or delete the conditions in a scaleup or scaledown rule. Before you update an AutoScale configuration, ensure that you disable the AutoScale load balancer rule by clicking the Disable AutoScale button.

After you modify the required AutoScale parameters, click Apply. To apply the new AutoScale policies, open the AutoScale configuration page again, then click the Enable AutoScale button.

Runtime Considerations¶

- An administrator should not assign a VM to a load balancing rule which is configured for AutoScale.

- Before a VM provisioning is completed if NetScaler is shutdown or restarted, the provisioned VM cannot be a part of the load balancing rule though the intent was to assign it to a load balancing rule. To workaround, rename the AutoScale provisioned VMs based on the rule name or ID so at any point of time the VMs can be reconciled to its load balancing rule.

- Making API calls outside the context of AutoScale, such as destroyVM, on an autoscaled VM leaves the load balancing configuration in an inconsistent state. Though VM is destroyed from the load balancer rule, NetScaler continues to show the VM as a service assigned to a rule.

Global Server Load Balancing Support¶

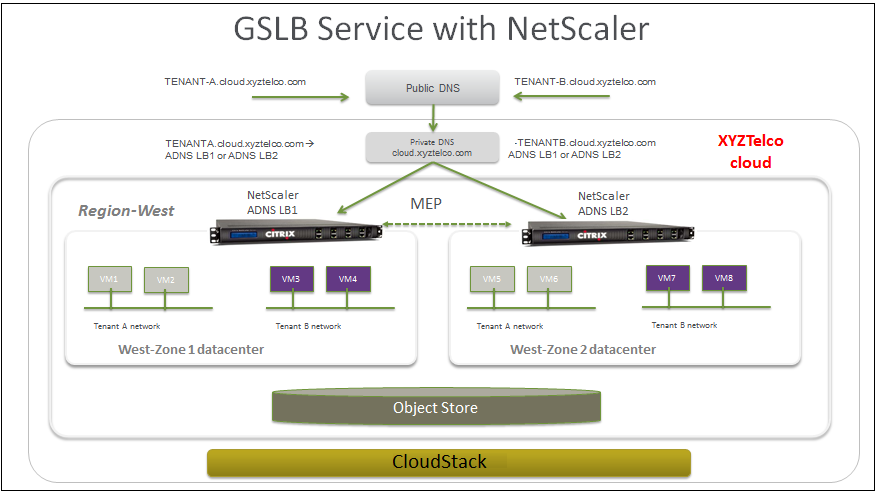

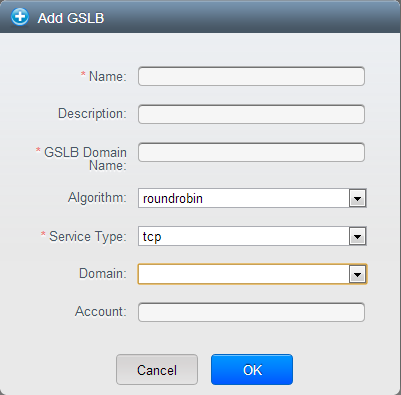

CloudStack supports Global Server Load Balancing (GSLB) functionalities to provide business continuity, and enable seamless resource movement within a CloudStack environment. CloudStack achieve this by extending its functionality of integrating with NetScaler Application Delivery Controller (ADC), which also provides various GSLB capabilities, such as disaster recovery and load balancing. The DNS redirection technique is used to achieve GSLB in CloudStack.

In order to support this functionality, region level services and service provider are introduced. A new service ‘GSLB’ is introduced as a region level service. The GSLB service provider is introduced that will provider the GSLB service. Currently, NetScaler is the supported GSLB provider in CloudStack. GSLB functionality works in an Active-Active data center environment.

About Global Server Load Balancing¶

Global Server Load Balancing (GSLB) is an extension of load balancing functionality, which is highly efficient in avoiding downtime. Based on the nature of deployment, GSLB represents a set of technologies that is used for various purposes, such as load sharing, disaster recovery, performance, and legal obligations. With GSLB, workloads can be distributed across multiple data centers situated at geographically separated locations. GSLB can also provide an alternate location for accessing a resource in the event of a failure, or to provide a means of shifting traffic easily to simplify maintenance, or both.

Components of GSLB¶

A typical GSLB environment is comprised of the following components:

- GSLB Site: In CloudStack terminology, GSLB sites are represented by zones that are mapped to data centers, each of which has various network appliances. Each GSLB site is managed by a NetScaler appliance that is local to that site. Each of these appliances treats its own site as the local site and all other sites, managed by other appliances, as remote sites. It is the central entity in a GSLB deployment, and is represented by a name and an IP address.

- GSLB Services: A GSLB service is typically represented by a load balancing or content switching virtual server. In a GSLB environment, you can have a local as well as remote GSLB services. A local GSLB service represents a local load balancing or content switching virtual server. A remote GSLB service is the one configured at one of the other sites in the GSLB setup. At each site in the GSLB setup, you can create one local GSLB service and any number of remote GSLB services.

- GSLB Virtual Servers: A GSLB virtual server refers to one or more GSLB services and balances traffic between traffic across the VMs in multiple zones by using the CloudStack functionality. It evaluates the configured GSLB methods or algorithms to select a GSLB service to which to send the client requests. One or more virtual servers from different zones are bound to the GSLB virtual server. GSLB virtual server does not have a public IP associated with it, instead it will have a FQDN DNS name.

- Load Balancing or Content Switching Virtual Servers: According to Citrix NetScaler terminology, a load balancing or content switching virtual server represents one or many servers on the local network. Clients send their requests to the load balancing or content switching virtual server’s virtual IP (VIP) address, and the virtual server balances the load across the local servers. After a GSLB virtual server selects a GSLB service representing either a local or a remote load balancing or content switching virtual server, the client sends the request to that virtual server’s VIP address.

- DNS VIPs: DNS virtual IP represents a load balancing DNS virtual server on the GSLB service provider. The DNS requests for domains for which the GSLB service provider is authoritative can be sent to a DNS VIP.

- Authoritative DNS: ADNS (Authoritative Domain Name Server) is a service that provides actual answer to DNS queries, such as web site IP address. In a GSLB environment, an ADNS service responds only to DNS requests for domains for which the GSLB service provider is authoritative. When an ADNS service is configured, the service provider owns that IP address and advertises it. When you create an ADNS service, the NetScaler responds to DNS queries on the configured ADNS service IP and port.

How Does GSLB Works in CloudStack?¶

Global server load balancing is used to manage the traffic flow to a web site hosted on two separate zones that ideally are in different geographic locations. The following is an illustration of how GLSB functionality is provided in CloudStack: An organization, xyztelco, has set up a public cloud that spans two zones, Zone-1 and Zone-2, across geographically separated data centers that are managed by CloudStack. Tenant-A of the cloud launches a highly available solution by using xyztelco cloud. For that purpose, they launch two instances each in both the zones: VM1 and VM2 in Zone-1 and VM5 and VM6 in Zone-2. Tenant-A acquires a public IP, IP-1 in Zone-1, and configures a load balancer rule to load balance the traffic between VM1 and VM2 instances. CloudStack orchestrates setting up a virtual server on the LB service provider in Zone-1. Virtual server 1 that is set up on the LB service provider in Zone-1 represents a publicly accessible virtual server that client reaches at IP-1. The client traffic to virtual server 1 at IP-1 will be load balanced across VM1 and VM2 instances.